Verbindungs-Multiplexing: HTTP/2-Stream-Verwaltung für TTFB

Die Verbindungs-Multiplexierung hat die Art und Weise revolutioniert, wie moderne Webprotokolle die Datenübertragung handhaben, insbesondere mit dem Aufkommen von HTTP/2. Diese Technologie ermöglicht es, mehrere Datenströme über eine einzige Verbindung zu teilen, was die Webleistung und das Benutzererlebnis erheblich verbessert. Ein Blick in die Mechanik des HTTP/2-Stream-Managements zeigt, wie Multiplexing die Seitenladegeschwindigkeit optimiert und die Latenz reduziert, wodurch neue Maßstäbe für eine effiziente Webkommunikation gesetzt werden.

Verständnis der Verbindungs-Multiplexierung und ihrer Rolle bei der HTTP/2-Leistung

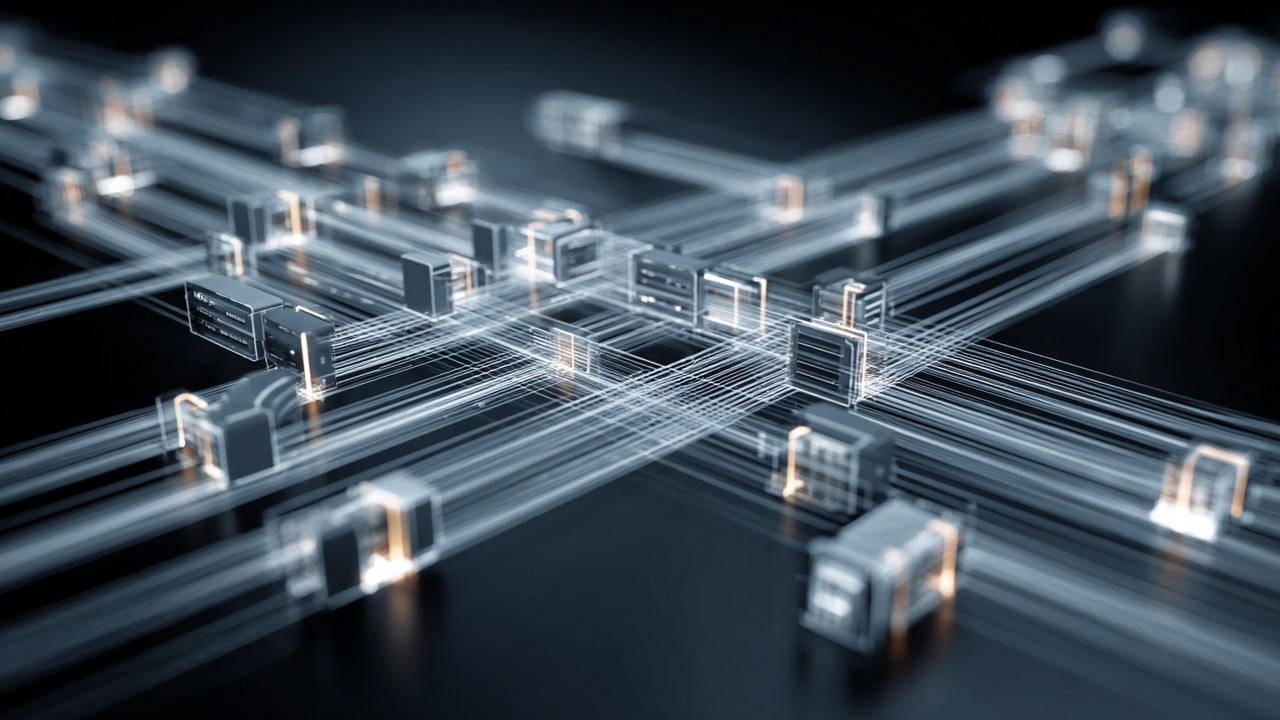

Verbindungs-Multiplexierung bezeichnet die Technik, mehrere unabhängige Datenströme gleichzeitig über eine einzige Netzwerkverbindung zu senden. Im Kontext von HTTP/2 verändert dieser Ansatz grundlegend, wie Webclients und Server im Vergleich zum älteren HTTP/1.1-Protokoll kommunizieren. Während HTTP/1.1 typischerweise mehrere TCP-Verbindungen öffnet, um parallele Anfragen zu bearbeiten, verwendet HTTP/2 eine einzige TCP-Verbindung, über die mehrere Streams multiplexiert werden.

Diese Veränderung ist bedeutend, da HTTP/2 das Konzept der Streams einführt – logische, unabhängige Kanäle innerhalb derselben physischen Verbindung. Jeder Stream trägt eine diskrete Sequenz von Frames, die HTTP-Anfragen und -Antworten repräsentieren. Dieses HTTP/2-Stream-Management ermöglicht es Browsern und Servern, mehrere Anfragen gleichzeitig zu senden und zu empfangen, ohne den Aufwand, für jede einzelne eine neue Verbindung aufzubauen.

Die Vorteile des HTTP/2-Multiplexings sind tiefgreifend. Durch die Konsolidierung mehrerer Datenaustausche in einer Verbindung reduzieren multiplexierte Verbindungen die durch das Einrichten und Abbrechen von TCP-Verbindungen verursachte Latenz. Diese Reduzierung des Overheads führt direkt zu schnelleren Seitenladezeiten und verbesserter Reaktionsfähigkeit. Darüber hinaus vermeidet Multiplexing die Einschränkungen der seriellen Anfragenbearbeitung von HTTP/1.1 und ermöglicht eine effizientere Nutzung der verfügbaren Bandbreite.

Ein wichtiger Aspekt der Verbindungs-Multiplexierung ist ihre Rolle bei der Minderung von Netzwerküberlastung und den Auswirkungen von Paketverlusten. Da alle Streams dieselbe TCP-Verbindung teilen, verwendet das Protokoll fortschrittliche Flusskontroll- und Priorisierungsmechanismen, um sicherzustellen, dass kritische Ressourcen auch bei schwankenden Netzwerkbedingungen schnell geladen werden.

Praktisch bedeutet dies, dass moderne Websites, die HTTP/2-Multiplexverbindungen nutzen, reichhaltigere Inhalte schneller bereitstellen können, was das Benutzererlebnis und die Zufriedenheit verbessert. Die Fähigkeit, mehrere Streams über eine einzige Verbindung zu verwalten, vereinfacht zudem die Server-Ressourcenverwaltung und verringert die Wahrscheinlichkeit von verbindungsbedingten Engpässen.

Insgesamt verkörpert die Verbindungs-Multiplexierung einen zentralen Fortschritt im Design von Webprotokollen. Ihre Integration in HTTP/2 definiert nicht nur die Stream-Verwaltung neu, sondern setzt auch eine neue Basislinie dafür, wie Leistungsoptimierung in der Webentwicklung angegangen wird. Durch die Ermöglichung mehrerer gleichzeitiger Streams innerhalb einer einzigen TCP-Verbindung spielt das HTTP/2-Multiplexing eine entscheidende Rolle bei der Reduzierung der Latenz, der Steigerung der Seitenladegeschwindigkeit und der Förderung der Entwicklung schnellerer, effizienterer Web-Erlebnisse.

Wie das HTTP/2-Stream-Management die Time to First Byte (TTFB) beeinflusst

Die Time to First Byte (TTFB) ist eine entscheidende Kennzahl in der Web-Performance, die die Dauer zwischen der Anfrage eines Clients und dem Eintreffen des ersten Bytes der Serverantwort misst. Diese Kennzahl ist nicht nur wichtig, um die Ladegeschwindigkeit einer Seite zu verstehen, sondern spielt auch eine wesentliche Rolle bei SEO-Rankings und der Benutzererfahrung. Niedrigere TTFB-Werte deuten typischerweise auf einen reaktionsschnelleren Server und eine optimierte Netzwerkstruktur hin, was von Suchmaschinen mit besserer Sichtbarkeit belohnt wird.

Die Beziehung zwischen HTTP/2-Stream-Management und TTFB-Optimierung ist eng miteinander verbunden. Durch die Nutzung von Multiplexing kann HTTP/2 mehrere Anfragen gleichzeitig über eine einzige Verbindung abwickeln und so Verzögerungen minimieren, die bei HTTP/1.1 traditionell die TTFB in die Länge ziehen. Beim früheren Protokoll mussten Browser oft warten, bis eine Anfrage abgeschlossen war, bevor sie eine neue starten konnten, was durch das Head-of-Line-(HOL)-Blocking verursacht wurde und die TTFB stark beeinträchtigte.

HTTP/2 löst dieses Problem, indem es mehreren Streams erlaubt, gleichzeitig zu existieren und unabhängig voneinander verarbeitet zu werden. Dieses Modell der multiplexen Verbindung reduziert die Wartezeit auf das erste Byte nachfolgender Ressourcen erheblich. Wenn beispielsweise eine Webseite gleichzeitig CSS, JavaScript und Bilder anfordert, kann HTTP/2 diese Anfragen parallel in verschiedenen Streams senden, ohne warten zu müssen, bis eine Anfrage abgeschlossen ist, bevor die nächste beginnt.

Mechanismen wie Stream-Priorisierung und Flusskontrolle verbessern die Effizienz dieses Prozesses zusätzlich. Das HTTP/2-Stream-Management weist verschiedenen Streams Prioritätsstufen zu, sodass kritische Ressourcen wie HTML und CSS vor weniger wichtigen Assets wie Bildern oder Schriftarten geliefert werden. Diese Priorisierung wirkt sich direkt auf die TTFB aus, indem die Bereitstellung der Ressourcen beschleunigt wird, die das initiale Rendering der Webseite beeinflussen.

Ein wesentlicher technischer Unterschied, der die TTFB beeinflusst, ist, wie HTTP/2 das bei HTTP/1.1 verbreitete HOL-Blocking-Problem eliminiert. Bei HTTP/1.1 müssen alle nachfolgenden Pakete warten, wenn ein Paket in einer Verbindung verzögert oder verloren geht, was die TTFB erhöht. Im Gegensatz dazu können die multiplexen Streams von HTTP/2 unabhängig voneinander weiterlaufen, sodass Verzögerungen in einem Stream die anderen nicht aufhalten.

Anhand von Praxisbeispielen berichten Websites, die auf HTTP/2 umgestellt haben, oft von erheblichen Verbesserungen der TTFB. Fallstudien zeigen Reduzierungen der TTFB um bis zu 30-40 %, was sich in deutlich schnelleren Ladezeiten und verbesserten Nutzerbindungswerten niederschlägt. Diese Verbesserungen unterstreichen den praktischen Vorteil der Nutzung von HTTP/2-Multiplexing zur Verringerung der TTFB.

Zusammenfassend optimiert das fortschrittliche Stream-Management von HTTP/2 die TTFB, indem es mehrere Anfragen gleichzeitig verarbeitet, kritische Daten priorisiert und die Beschränkungen von HTTP/1.1 überwindet. Diese Optimierung verbessert nicht nur die HTTP/2-Leistung, sondern trägt auch zu besseren SEO-Ergebnissen bei, indem schnellere und reaktionsfähigere Websites bereitgestellt werden, die sowohl Nutzer als auch Suchmaschinen zufriedenstellen.

Technischer Deep Dive in HTTP/2-Stream-Priorisierung und Flusskontrolle

Ein grundlegender Aspekt der effizienten HTTP/2-Stream-Priorisierung liegt in der Fähigkeit, die Reihenfolge zu steuern, in der Ressourcen geladen werden. Jeder Stream in HTTP/2 kann mit einem Gewicht und einer Abhängigkeit versehen werden, wodurch Client und Server die Wichtigkeit von Ressourcen kommunizieren können. Dieses System stellt sicher, dass wichtige Komponenten, wie das Haupt-HTML-Dokument oder kritisches CSS, vor weniger dringenden Assets übertragen werden.

Die Flusskontrolle in HTTP/2 ergänzt die Priorisierung, indem sie steuert, wie viel Daten zu einem bestimmten Zeitpunkt auf jedem Stream gesendet werden können. Dieser Mechanismus verhindert, dass ein einzelner Stream die gesamte Verbindungsbandbreite monopolisiert, und sorgt so für eine faire Verteilung der Netzwerkressourcen über mehrere Streams hinweg. Die Flusskontrolle wird durch Fensteraktualisierungen umgesetzt, die regeln, wie viel Daten ein Sender übertragen darf, bevor er eine Bestätigung vom Empfänger erhält.

Gemeinsam schaffen Priorisierung und Flusskontrolle ein Gleichgewicht, das den Durchsatz maximiert und gleichzeitig die Latenz minimiert. Wenn beispielsweise ein Stream mit hoher Priorität die Haupt-HTML-Seite anfordert, kann der Server diesem Stream mehr Bandbreite zuweisen, um die Lieferung zu beschleunigen und die Nutzererfahrung insgesamt zu verbessern.

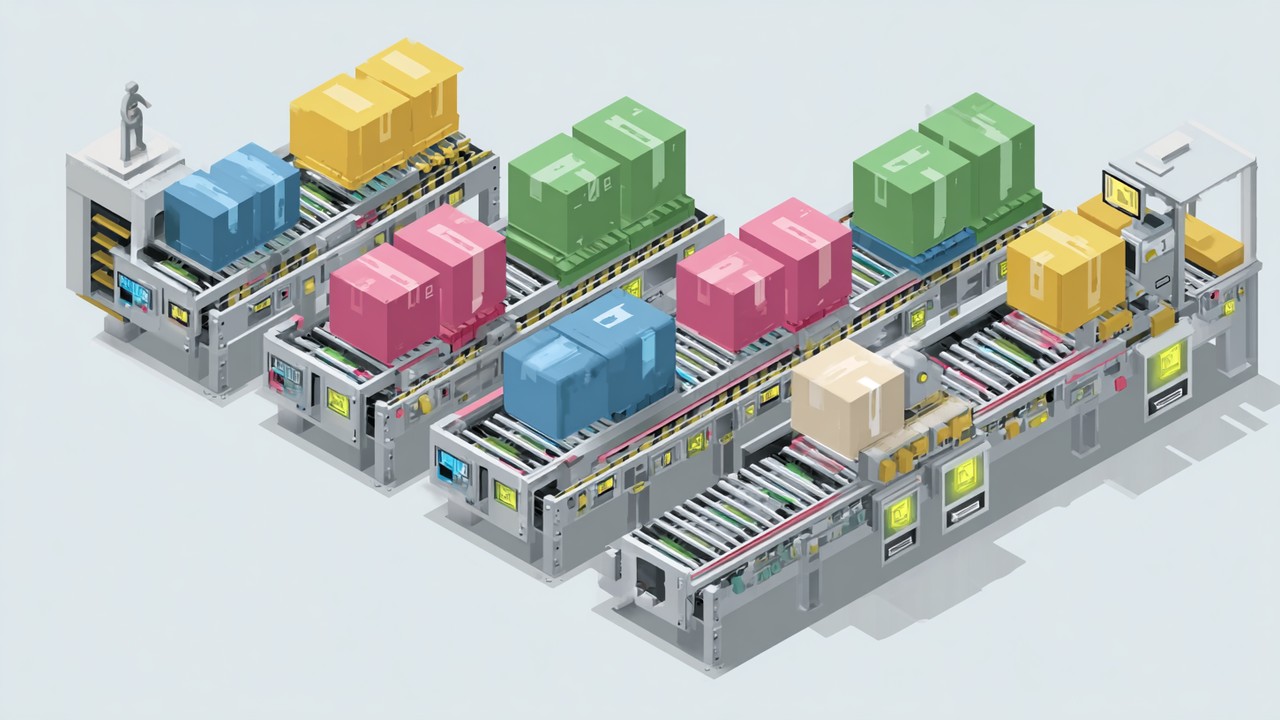

Zur Veranschaulichung betrachten wir ein vereinfachtes Szenario: Ein Browser fordert drei Ressourcen an – HTML (hohe Priorität), CSS (mittlere Priorität) und Bilder (niedrige Priorität). Die Priorisierung von HTTP/2 sorgt dafür, dass der HTML-Stream zuerst bedient wird, gefolgt vom CSS, während die Bilder zuletzt geladen werden. Die Flusskontrolle regelt diese Streams so, dass kein einzelner Stream die anderen blockiert und ein reibungsloser Datenfluss gewährleistet ist.

Diese Mechanismen sind entscheidend, um die Effizienz der multiplexen Streams aufrechtzuerhalten. Ohne angemessene Priorisierung könnte das Multiplexing allein zu Ressourcenkonflikten führen, bei denen weniger wichtige Streams Bandbreite auf Kosten kritischer Streams verbrauchen, was sich negativ auf TTFB und Seitenladegeschwindigkeit auswirkt.

Um sich diesen Prozess bildlich vorzustellen, kann man ein Förderband vorstellen, auf dem priorisierte Pakete vorne platziert werden, während die Flusskontrolle als Torwächter fungiert, der reguliert, wie viele Pakete gleichzeitig passieren dürfen. Diese Orchestrierung sorgt für eine gleichmäßige und geordnete Bereitstellung der Ressourcen und optimiert so die Web-Performance.

Zusammenfassend ist die Kombination aus Stream-Priorisierung und Flusskontrolle bei HTTP/2 essenziell für die effektive Verwaltung multiplexer Verbindungen. Diese Synergie stellt sicher, dass kritische Ressourcen zeitnah geliefert werden, was TTFB und die Gesamtreaktionsfähigkeit der Website verbessert. Das Verständnis und die Nutzung dieser technischen Funktionen sind für Entwickler von großer Bedeutung, die ihre HTTP/2-Implementierungen optimieren möchten.

Best Practices zur Nutzung von HTTP/2-Multiplexing zur Verbesserung der Web-Performance

Um die Vorteile des HTTP/2-Multiplexings vollständig auszuschöpfen und die Geschwindigkeit sowie Reaktionsfähigkeit von Websites zu verbessern, müssen Entwickler und Seitenbetreiber gezielte Strategien zur Optimierung des Stream-Managements anwenden. Effektives HTTP/2-Performance-Tuning umfasst sowohl server- als auch clientseitige Konfigurationen, sorgfältige Ressourcenpriorisierung und kontinuierliches Monitoring, um Latenzen zu reduzieren und TTFB zu verbessern.

Server- und Clientseitige Einstellungen optimieren

Auf der Serverseite ist die Aktivierung von HTTP/2-Unterstützung der grundlegende Schritt. Die meisten modernen Webserver wie Apache, Nginx und IIS unterstützen HTTP/2, aber eine korrekte Konfiguration ist entscheidend, um die Vorteile multiplexierter Verbindungen zu nutzen. Zum Beispiel:

- HTTP/2 mit TLS aktivieren: Da HTTP/2 überwiegend über HTTPS eingesetzt wird, sorgt eine robuste TLS-Konfiguration mit modernen Cipher-Suites für Sicherheit ohne Geschwindigkeitseinbußen.

- Limits für gleichzeitige Streams konfigurieren: Servereinstellungen sollten so angepasst werden, dass eine optimale Anzahl gleichzeitiger Streams pro Verbindung erlaubt ist, um Ressourcenverfügbarkeit und Last auszubalancieren.

- Effiziente Priorisierungsrichtlinien implementieren: Server können so eingestellt werden, dass sie die Prioritäten der Client-Streams respektieren und kritische Assets zeitnah liefern.

Auf der Clientseite ergänzt die Minimierung unnötiger Anfragen und das sinnvolle Bündeln von Ressourcen das Multiplexing. Obwohl HTTP/2 die Notwendigkeit der Ressourcen-Konkatenation reduziert, können zu viele parallele Streams die Flusskontrollmechanismen überlasten und die Performance verschlechtern. Ein ausgewogenes Verhältnis ist entscheidend.

TTFB und Multiplexing-Effektivität messen

Zur Erfolgskontrolle sind zuverlässige Messwerkzeuge erforderlich, die sowohl TTFB als auch HTTP/2-Multiplexing-Metriken erfassen. Beliebte Web-Performance-Tools sind:

- WebPageTest: Bietet detaillierte Wasserfalldiagramme, die zeigen, wie multiplexierte Streams interagieren und TTFB beeinflussen.

- Chrome DevTools: Liefert Echtzeit-Einblicke in Netzwerk-Anfragen, Stream-Priorisierung und Zeitaufteilungen.

- Lighthouse: Bewertet die Gesamtseitenperformance und hebt Bereiche hervor, in denen HTTP/2-Multiplexing Vorteile bringen kann.

Die regelmäßige Analyse dieser Metriken hilft, Engpässe durch ineffizientes Stream-Management oder Serverfehlkonfigurationen zu identifizieren.

Häufige Fehler beim Multiplexing vermeiden

Obwohl HTTP/2-Multiplexing viele Vorteile bietet, kann eine falsche Implementierung unerwünschte Folgen haben:

- Ineffiziente Stream-Priorisierung: Ohne korrekte Priorisierung können kritische Ressourcen verzögert werden, was die TTFB-Verbesserungen zunichtemacht.

- Zu viele parallele Streams: Das gleichzeitige Öffnen zu vieler Streams kann die Flusskontrollfenster überlasten, was zu Staus und erhöhter Latenz führt.

- Ignorieren von Legacy-HTTP/1.1-Clients: Einige Nutzer verbinden sich noch über HTTP/1.1, daher sind Fallback-Mechanismen und Optimierungen für beide Protokolle notwendig.

Das Bewusstsein für diese Fallstricke sorgt für einen reibungsloseren Übergang zu HTTP/2 und nachhaltige Performanceverbesserungen.

Multiplexing mit anderen Optimierungstechniken kombinieren

HTTP/2-Multiplexing entfaltet seine volle Wirkung in Kombination mit ergänzenden Performance-Strategien:

- Caching: Nutzung von Browser- und Serverseitigem Caching reduziert redundante Anfragen und entlastet die Streams.

- Content Delivery Networks (CDNs): Geografisch verteilte Inhalte verkürzen die Round-Trip-Zeiten und verstärken die Multiplexing-Vorteile.

- Ressourcenkompression und Minifizierung: Kleinere Datenmengen beschleunigen die Übertragung und machen multiplexierte Streams effizienter.

- Lazy Loading: Das Verzögern nicht-kritischer Ressourcen optimiert die Stream-Priorisierung und reduziert das initiale TTFB.

Diese Taktiken bilden zusammen einen ganzheitlichen Ansatz zur Web-Performance und verstärken die Vorteile der multiplexierten HTTP/2-Verbindungen.

Abschließende Empfehlungen

Um HTTP/2-Multiplexing effektiv zu optimieren, sollten Seitenbetreiber:

- Sicherstellen, dass HTTP/2 aktiviert und korrekt auf dem Server konfiguriert ist.

- TTFB und Stream-Aktivitäten mit spezialisierten Tools überwachen.

- Kritische Ressourcen präzise priorisieren, um Verzögerungen zu vermeiden.

- Die Anzahl gleichzeitiger Streams verwalten, um Staus zu verhindern.

- Multiplexing mit Caching, CDNs und Kompression kombinieren, um maximale Wirkung zu erzielen.

Durch die Beachtung dieser Best Practices können Websites erhebliche Reduzierungen des TTFB erreichen, Inhalte schneller bereitstellen und verbesserte Nutzererfahrungen bieten, die sich positiv auf SEO und Nutzerbindung auswirken.

Bewertung der Auswirkungen von Verbindungs-Multiplexing auf die reale Website-Geschwindigkeit und SEO

Die Einführung von HTTP/2 und seiner multiplexierten Verbindungsmöglichkeiten hat nachweisbare Effekte auf die Website-Geschwindigkeit und die SEO-Leistung. Studien zeigen konsistent, dass Websites, die HTTP/2 nutzen, eine schnellere TTFB aufweisen, was stark mit verbesserten Suchmaschinen-Rankings und höherer Nutzerzufriedenheit korreliert.

Einfluss des Verbindungs-Multiplexings auf SEO-Rankings

Suchmaschinen priorisieren Nutzererfahrungssignale wie Seitenladegeschwindigkeit und Reaktionsfähigkeit. Da Verbindungs-Multiplexing die Latenz reduziert, indem es gleichzeitige Datenströme ermöglicht, trägt es direkt zu einer schnelleren Inhaltslieferung bei. Diese Verbesserung der TTFB ist besonders wichtig für mobile Nutzer oder solche mit Netzwerken mit hoher Latenz, bei denen Verzögerungen die Absprungraten und das Engagement erheblich beeinflussen können.

Reale Daten zeigen, dass Seiten, die HTTP/2-Multiplexing nutzen, aufgrund besserer Ladekennzahlen oft höher ranken. Eine schnellere TTFB bedeutet, dass Suchmaschinen-Crawler Inhalte schneller erhalten, was eine effizientere Indexierung und bessere Ranking-Signale ermöglicht.

Verbesserte Nutzererfahrung und Engagement

Über SEO hinaus führen die Geschwindigkeitsvorteile von HTTP/2-Multiplexing zu spürbaren Verbesserungen der Nutzererfahrung. Kürzere Wartezeiten fördern längere Seitenbesuche, höhere Konversionsraten und geringere Absprungraten. Studien belegen, dass selbst Millisekunden, die bei der TTFB eingespart werden, die Nutzerbindung erhöhen können, wodurch Multiplexing ein wertvolles Instrument für das Unternehmenswachstum ist.

Vergleichsszenarien: Mit und ohne HTTP/2-Multiplexing

Beim Vergleich von Websites mit aktiviertem HTTP/2-Multiplexing gegenüber solchen, die HTTP/1.1 oder unoptimiertes HTTP/2 verwenden, werden Unterschiede in Geschwindigkeit und SEO deutlich:

- Ohne Multiplexing: Mehrere TCP-Verbindungen erzeugen Overhead, erhöhen die TTFB und verlangsamen die Ressourcenlieferung.

- Mit Multiplexing: Einzelne Verbindungen verwalten viele Streams effizient, reduzieren die Latenz und beschleunigen das Seitenrendering.

Dieser Kontrast unterstreicht den strategischen Vorteil der Einführung von HTTP/2 für moderne Webinfrastrukturen.

Strategische Empfehlungen für Unternehmen

Für Unternehmen, die SEO und Website-Geschwindigkeit verbessern wollen, ist der Umstieg auf HTTP/2 mit korrekter Multiplexing-Unterstützung ein entscheidender Schritt. Dies erfordert Investitionen in Server-Upgrades, Konfigurationsoptimierung und kontinuierliches Performance-Monitoring, bringt jedoch erhebliche Vorteile bei Suchmaschinen-Rankings und Nutzerengagement.

Darüber hinaus maximiert die Integration von Multiplexing mit anderen Optimierungsstrategien – wie Caching, CDNs und Kompression – die Performance-Steigerungen.

Wichtige Erkenntnisse zum strategischen Wert des Verbindungs-Multiplexings

- Verbindungs-Multiplexing ist ein grundlegendes Element von HTTP/2, das die Datenübertragung beschleunigt, indem es mehrere Streams gleichzeitig verarbeitet.

- Diese Technologie reduziert die TTFB signifikant, eine wichtige Kennzahl für SEO und Nutzererfahrung.

- Eine korrekte Stream-Verwaltung, Priorisierung und Flusskontrolle sind essenziell, um die Vorteile des Multiplexings vollständig auszuschöpfen.

- Empirische Belege unterstützen die SEO- und Performance-Vorteile der HTTP/2-Multiplexing-Einführung.

- Unternehmen, die ihre Webinfrastruktur mit HTTP/2-Multiplexing verbessern, positionieren sich für bessere Suchmaschinen-Rankings, schnellere Ladezeiten und höheres Nutzerengagement.

Die Integration von Verbindungs-Multiplexing als Teil einer umfassenden Web-Performance-Strategie ist für Organisationen, die sich im heutigen digitalen Umfeld einen Wettbewerbsvorteil sichern wollen, unverzichtbar.